ChatGPT & Co. und Schule

Allgemeines

Was tun?

Weiteres

Vertiefendes

Weiterführendes

Unser Material

Unsere Kurse

Webtechnisches

Zukünftige Entwicklung

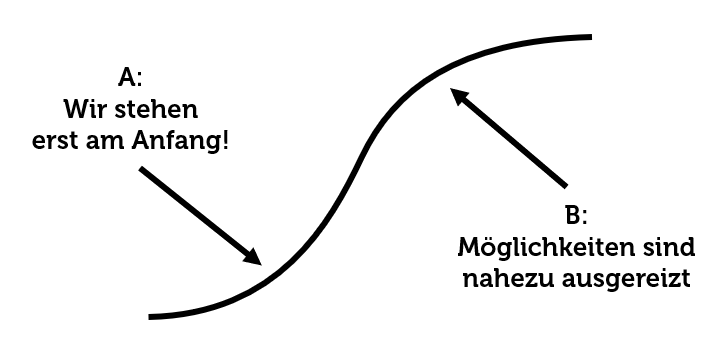

Derzeit sind sich Expertinnen und Experten uneinig, wie sich die Leistungsfähigkeit von allgemeinen generativen Machine-Learning-Systemen entwickeln wird. Während die einen davon ausgehen, dass wir erst am Anfang einer grösseren Entwicklung stehen, sehen andere das derzeit Erreichte eher als Ende einer längeren Entwicklung. Eine zuverlässige Prognose ist praktisch unmöglich.

Gründe, die gegen eine weitere, massive Leistungssteigerung sprechen

- Ende des klassischen Moore'schen Gesetzes: Das Moore'sche Gesetz - einer der Haupttreiber der GMLS-Entwicklung - ist zu einem Ende gekommen, da sich die Strukturen in heutigen Prozessoren nicht mehr weiter verkleinern lassen.

- Verfügbare Daten bereits ausgeschöpft: Bisherige Systeme sind unter anderem leistungsfähiger geworden, weil ihnen mehr Trainingsdaten zur Verfügung standen. Aktuelle Einschätzungen zeigen aber, dass die meisten weltweit verfügbaren Daten bereits als Trainingsdaten verwendet werden - es sind schlicht nicht 100 Mal mehr Trainingsdaten verfügbar. (Biblionetz:a1544)

- Modellvergiftung durch generierte Daten: Bisherige Erkenntnisse zeigen, dass GMLS-Modelle schlechter werden, wenn sie mit künstlich generierten Daten trainiert werden (also sozusagen ihren eigenen Output wieder als Trainingsinput vorgesetzt erhalten. Insbesondere auf dem frei verfügbaren Internet werden aber zunehmend mehr Daten maschinell erzeugt sein. Somit besteht die Befürchtung, dass die sinkende Datenqualität zu einer Leistungseinbusse von mit solchen Daten trainierten Systemen führen könnte.

- Explodierender Energiebedarf: Wenn es nicht gelingt, generative Machine-Learning-Systeme massiv effizienter zu gestalten, so scheitert eine grössere Steigerung der Leistungsfähigkeit am massiv zunehmenden Energiebedarf solcher Systeme.

Gründe, die für eine weitere, massive Leistungssteigerung sprechen

- Wirtschaftliche Interessen: Das wirtschaftliche Interesse am Thema ist gross, deshalb dürfte viel Entwicklungsaufwand getrieben werden, um die Systeme zu verbessern.

- Grössere Hardwareleistung: Zwar lassen sich nicht mehr Bauteile pro Chipfläche unterbringen, aber dafür lassen sich heute einfacher grössere Chips herstellen, so dass die verfügbare Rechenleistung weiterhin stark zunehmen dürfte.

- Optimierung in verschiedenen Bereichen: In verschiedenen Bereichen (Chipdesign, Algorithmen, Training) besteht noch grosses Optimierungspotenzial. Insbesondere mit maschinellem Lernen lässt sich die Optimierung optimieren.

Spezialisierung und Kombination als weitere Variante der Leistungssteigerung

Neben der Hoffnung auf eine allgemeine Leistungssteigerung besteht auch die Möglichkeit, dass sich die Leistungsfähigkeit und Effizienz gewisser GMLS steigern lässt, indem sie auf bestimmte Aufgaben und/oder Themenbereiche fokussiert erstellt werden und in einem engeren Bereich massiv bessere Leistungen zeigen oder weniger Ressourcen verbrauchen. Auch die Kombination oder Aneinanderreihung von mehreren GML könnte zu Leistungssteigerungen führen (Z.B.: ein GMLS plant die Ausführung anderer GMLS).

Potenzialausschöpfung durch Menschen als Leistungssteigerung

Neben der reinen Leistungssteigerung von generativen Machine-Learning-Systemen ist zu erwarten, dass Menschen künftig besser erkennen, wo und wie sie solche Systeme nutzbringend einsetzen können. Es ist deshalb zu erwarten, dass der allgemeine Nutzen solcher Systeme selbst dann zunehmen würde, wenn die Systeme technisch nicht mehr verbessert würden. Die Website gmls.phsz.ch ist eine seit Dezember 2022 laufend erweiterte Sammlung von Einordnungen der Professur "Digitalisierung und Bildung" der Pädagogischen Hochschule Schwyz zur Frage, welche Auswirkungen generative Machine-Learning-Systeme wie ChatGPT auf die Schule haben.

Lizenz: Die Website steht unter einer CC-BY-ND-Lizenz, Bilder und Texte dürfen somit unter Quellenangabe an anderen Orten verwendet werden.

Zitationsvorschlag: Döbeli Honegger, Beat (2022-2026). ChatGPT & Co. und Schule. Einschätzungen der Professur "Digitalisierung und Bildung" der Pädagogischen Hochschule Schwyz. https://gmls.phsz.ch/ (abgerufen am 27 Jan 2026)

Alternativer Zitationsvorschlag: Insgesamt besteht gmls.phsz.ch aus ca. 50 einzelnen Seiten. Wesentliche Inhalte dieser Website sind auch in der folgenden, frei verfügbaren Publikation zu finden: Döbeli Honegger, Beat (2025). Generative Machine-Learning-Systeme - Die nächste Herausforderung des digitalen Leitmedienwechsels

Die Website gmls.phsz.ch ist eine seit Dezember 2022 laufend erweiterte Sammlung von Einordnungen der Professur "Digitalisierung und Bildung" der Pädagogischen Hochschule Schwyz zur Frage, welche Auswirkungen generative Machine-Learning-Systeme wie ChatGPT auf die Schule haben.

Lizenz: Die Website steht unter einer CC-BY-ND-Lizenz, Bilder und Texte dürfen somit unter Quellenangabe an anderen Orten verwendet werden.

Zitationsvorschlag: Döbeli Honegger, Beat (2022-2026). ChatGPT & Co. und Schule. Einschätzungen der Professur "Digitalisierung und Bildung" der Pädagogischen Hochschule Schwyz. https://gmls.phsz.ch/ (abgerufen am 27 Jan 2026)

Alternativer Zitationsvorschlag: Insgesamt besteht gmls.phsz.ch aus ca. 50 einzelnen Seiten. Wesentliche Inhalte dieser Website sind auch in der folgenden, frei verfügbaren Publikation zu finden: Döbeli Honegger, Beat (2025). Generative Machine-Learning-Systeme - Die nächste Herausforderung des digitalen Leitmedienwechsels  In: Brägger, Gerold & Rolff, Hans-Günter: Handbuch Lernen mit digitalen Medien (3. Auflage). Beltz Verlag. https://zenodo.org/records/15042499

In: Brägger, Gerold & Rolff, Hans-Günter: Handbuch Lernen mit digitalen Medien (3. Auflage). Beltz Verlag. https://zenodo.org/records/15042499

This page was cached on 27 Jan 2026 - 06:15.

This website is using cookies. More info.

That's Fine