ChatGPT & Co. und Schule

Allgemeines

Was tun?

Weiteres

Vertiefendes

Weiterführendes

Unser Material

Unsere Kurse

Webtechnisches

Technische Perspektive

Die folgenden technischen Einschätzungen erfordern kein technisches Vorwissen, sind allgemeinverständlich formuliert und gehen nicht detailliert auf die Funktionsweise generativer Machine-Learning-Systeme ein (dazu findet sich mehr unter Funktionsweise).- ChatGPT ist nur ein Schritt in einer längeren Entwicklung

ChatGPT ist bei weitem nicht das erste Computerprogramm, welches einen umgangssprachlichen Dialog mit einem Computer ermöglicht. Bereits zwischen 1964 bis 1966 entwickelte der deutsch-amerikanische Informatiker Joseph Weizenbaum mit Eliza einen Chatroboter, der einige Bekanntheit erreichte. Weizenbaum hat auf einfachste Weise einen empathischen Psychiater zu simulieren versucht, der auf Antworten mit entsprechenden Nachfragen reagiert und war danach erschrocken darüber, wie ernst seine Umgebung den Chatroboter genommen hat. Während Eliza noch explizit programmiert worden war, ist ChatGPT ein sogenanntes Large Language Model, das unter anderem auf neuronalen Netzwerken beruht. Derzeit nutzt ChatGPT die Versionen 5 von GPT - die Version 1 von GPT wurde 2018 entwickelt.

Es gibt mindestens drei Gründe, warum die aktuellen Fähigkeiten von ChatGPT nur eine Momentaufnahme darstellen:- Zunehmende Rechenleistung: Das Moore'sche Gesetz sowie effizientere Hardware und Algorithmen sorgen dafür, dass Sprachgeneratoren künftig noch leistungsfähiger werden.

- Konkurrenzprodukte: OpenAI ist nicht das einzige Unternehmen, das generative Machine-Learning-Systeme entwickelt.

- Macht der Schnittstellen: Die Mächtigkeit des Digitalen beruht unter anderem darauf, dass sich IT-Systeme mit Hilfe von Schnittstellen kombinieren lassen und sich daraus neue, mächtigere Gesamtsysteme ergeben. Auch bei generativen Machine-Learning-Systemen ist in naher Zukunft eine Explosion von kombinierten Systemen zu erwarten, bei denen die Potenziale von generativen Machine-Learning-Systemen mit anderen Systemen gekoppelt neue Möglichkeiten bieten werden. Dass OpenAI die entsprechende Schnittstelle (API) zu GPT zur Verfügung gestellt hat, war der erste pragmatische Schritt dazu.

- Es geht nicht nur um Text, sondern um alles, was sich digital repräsentieren lässt

Mittels generativer Machine-Learning-Systeme lassen sich alle digital repräsentierbaren Objekte (Texte, Bilder, Töne, Videos, 3D-Modelle, Proteine etc.) generieren bzw. von einer Datenform in eine andere Überführen (bspw. aus Bildern Bildbeschreibungen oder Musik erstellen.)

- Die Grenze des Möglichen ist nicht einfach zu benennen

Obwohl ChatGPT den aktuellen Stand einer längeren technologischen Entwicklung darstellt, sind sich Expertinnen und Experten nicht einig, wo die Grenze des technisch Möglichen liegt. Bei ChatGPT zeigten sich gewisse Expert:innen überrascht, welche Qualitätsverbesserung im Vergleich zu früheren GPT-Versionen in so kurzer Zeit möglich wurde - u.a. durch mehr Daten und mehr Rechenleistung.

- ChatGPT ist ein sehr allgemeines Werkzeug, das mehr auf Breite als auf Tiefe setzt

ChatGPT ist ein generisches Werkzeug, das auf breite Anwendung ausgelegt ist. Es ist deshalb zu erwarten, dass künftige, auf spezielle Teilgebiete zugeschnittene Lösungen deutlich leistungsfähiger sein werden.

- ChatGPT & Co. haben gewisse Ähnlichkeiten mit Suchmaschinen

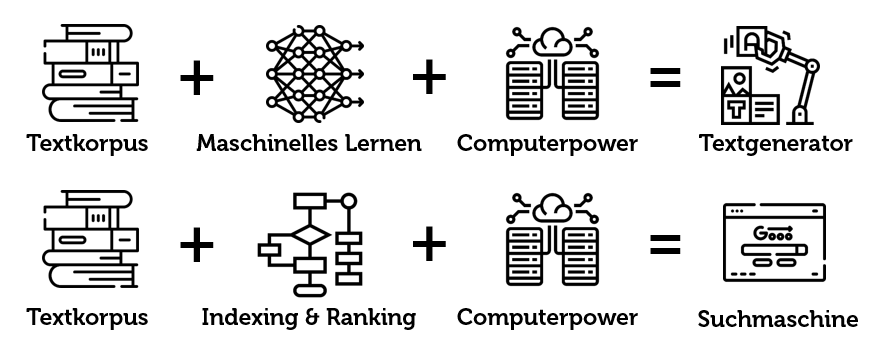

Sowohl generative Machine-Learning-Systeme als auch Suchmaschinen beruhen auf einem grossen Text- bzw. Datenkorpus. Während bei generativen Machine-Learning-Systemen mit grossem Rechenaufwand ein neuronales Netzwerk trainiert wird, findet bei Suchmaschinen ein Indexing- und Rankingprozess statt.

- Generative Maschine-Learning-Systeme beruhen auf statistischen Modellen und sind keine Logik-Maschinen

ChatGPT und Co. bauen ihre Antworten primär aufgrund von statistisch zu erwartenden Wörtern und Sätzen zusammen, deren Wahrscheinlichkeiten sie in ihrem Textkorpus gefunden haben. Es kommt deshalb mitunter vor, dass sie sachliche und/oder logische Fehler generieren.

- Generative Machine-Learning-Systeme beruhen auf statistischen Modellen und ihre Antworten kommen meist auch unter Zuhilfenahme von Zufall zustande

Sprachgeneratoren wie ChatGPT rechnen vereinfacht formuliert die wahrscheinlichste Antwort auf eine Eingabe/Anfrage aus. Dabei wird aber eine Prise Zufall beigemischt (Fachbegriff: Temperatur), was unter anderem zur Folge hat, dass auf die gleiche Eingabe/Anfrage nicht jedes Mal die gleiche Antwort errechnet wird.

- Bei der Diskussion gilt es kurzlebige Versionseigenschaften von mittelfristigen Produkteigenschaften und insbesondere von langfristigen Technologieeigenschaften zu unterscheiden

- Versionsspezifisch: Bei der seit November 2022 verfügbaren Version von ChatGPT handelt es sich um eine Testversion zur Verbesserung des Produkts. Die Interaktionen von Testnutzenden fliessen automatisiert und/oder manuell in den Dienst ein, so dass ChatGPT bereits nach einer Woche ganz anders auf gewisse Anfragen reagiert. Somit sind derzeit sogar Aussagen zum konkreten Produkt ChatGPT manchmal nur von zeitlich sehr begrenzter Gültigkeit.

- Produktspezifisch und darum langfristig nicht relevant für die Diskussion sind u.a. folgende Punkte:

- ChatGPT beruht auf einem Textkorpus von 2021 und bezieht bei Antworten das aktuelle Internet nicht mit ein

Dies ist eine produktspezifische Begrenzung von ChatGPT und kein grundsätzliches Hindernis. Bereits im Februar 2023 bestehen verschiedene Alternativprodukte, die aktuelle Daten aus dem Internet bei ihren Antworten berücksichtigen. - ChatGPT zitiert derzeit nicht korrekt (Zitierstil) und erfindet mitunter Quellen.

Dies sind beides Eigenschaften, die sich leicht korrigieren lassen in anderen Produkten, da sich sowohl die korrekte Zitierweise automatisieren und automatisiert prüfen lässt als auch eine automatische Prüfung auf die Existenz von Quellen leicht machbar ist. Auch hier existieren im Februar 2023 bereits Alternativprodukte, auf welche diese Kritik nicht oder nur noch teilweise zutrifft.

- ChatGPT beruht auf einem Textkorpus von 2021 und bezieht bei Antworten das aktuelle Internet nicht mit ein

- GMLS-Erkennungssoftware wird ein Wettrüsten auslösen, aber keine sichere Erkennung bringen

Die Entwicklung von Programmen zur Erkennung von computergenerierten Texten wird ein Wettrüsten zwischen ML-Textgenerierung und ML-Texterkennung auslösen, da Textgenerierungsprogramme die verfügbaren Erkennungsprogramme als zusätzlichen Filter / Trainingsmöglichkeit nutzen werden (GAN-Netzwerk mit Erkennungsalgorithmus als Diskriminator). Es wird somit vermutlich langfristig nicht möglich sein, computergenerierte Texte zuverlässig automatisiert erkennen zu können.

mehr...

- Generative Maschine-Learning-Systeme sind sehr energieintensiv

Sowohl das Training als auch die Nutzung von generativen Maschine-Learning-Systemen ist sehr rechen- und damit energieintensiv. Die Entwicklung ist sehr dynamisch, so dass es schwer prognostizierbar ist, wie sich der Engergiebedarf mittel- und langfristig auswirken wird.

mehr...

Die Website gmls.phsz.ch ist eine seit Dezember 2022 laufend erweiterte Sammlung von Einordnungen der Professur "Digitalisierung und Bildung" der Pädagogischen Hochschule Schwyz zur Frage, welche Auswirkungen generative Machine-Learning-Systeme wie ChatGPT auf die Schule haben.

Lizenz: Die Website steht unter einer CC-BY-ND-Lizenz, Bilder und Texte dürfen somit unter Quellenangabe an anderen Orten verwendet werden.

Zitationsvorschlag: Döbeli Honegger, Beat (2022-2026). ChatGPT & Co. und Schule. Einschätzungen der Professur "Digitalisierung und Bildung" der Pädagogischen Hochschule Schwyz. https://gmls.phsz.ch/ (abgerufen am 26 Jan 2026)

Alternativer Zitationsvorschlag: Insgesamt besteht gmls.phsz.ch aus ca. 50 einzelnen Seiten. Wesentliche Inhalte dieser Website sind auch in der folgenden, frei verfügbaren Publikation zu finden: Döbeli Honegger, Beat (2025). Generative Machine-Learning-Systeme - Die nächste Herausforderung des digitalen Leitmedienwechsels

Die Website gmls.phsz.ch ist eine seit Dezember 2022 laufend erweiterte Sammlung von Einordnungen der Professur "Digitalisierung und Bildung" der Pädagogischen Hochschule Schwyz zur Frage, welche Auswirkungen generative Machine-Learning-Systeme wie ChatGPT auf die Schule haben.

Lizenz: Die Website steht unter einer CC-BY-ND-Lizenz, Bilder und Texte dürfen somit unter Quellenangabe an anderen Orten verwendet werden.

Zitationsvorschlag: Döbeli Honegger, Beat (2022-2026). ChatGPT & Co. und Schule. Einschätzungen der Professur "Digitalisierung und Bildung" der Pädagogischen Hochschule Schwyz. https://gmls.phsz.ch/ (abgerufen am 26 Jan 2026)

Alternativer Zitationsvorschlag: Insgesamt besteht gmls.phsz.ch aus ca. 50 einzelnen Seiten. Wesentliche Inhalte dieser Website sind auch in der folgenden, frei verfügbaren Publikation zu finden: Döbeli Honegger, Beat (2025). Generative Machine-Learning-Systeme - Die nächste Herausforderung des digitalen Leitmedienwechsels  In: Brägger, Gerold & Rolff, Hans-Günter: Handbuch Lernen mit digitalen Medien (3. Auflage). Beltz Verlag. https://zenodo.org/records/15042499

In: Brägger, Gerold & Rolff, Hans-Günter: Handbuch Lernen mit digitalen Medien (3. Auflage). Beltz Verlag. https://zenodo.org/records/15042499

This page was cached on 26 Jan 2026 - 17:34.

This website is using cookies. More info.

That's Fine